2025-04-20

分享到

在机器学习领域里,不存在一种万能的算法可以完美解决所有问题,尤其是像预测建模的监督学习里。

所以,针对你要解决的问题,最好是尝试多种不同的算法。并借一个测试集来评估不同算法之间的表现,最后选出一个结果最好的。

比方说,要打扫房子,你会用真空吸尘器,扫把,拖把;你绝对不会翻出一把铲子来开始挖坑,对吧。

不过呢,对于所有预测建模的监督学习算法来说,还是有一些通用的底层原则的。

机器学习算法,指的是要学习一个目标函数,能够尽可能地还原输入和输出之间的关系。

然后根据新的输入值X,来预测出输出值Y。精准地预测结果是机器学习建模的任务。

做预测建模,最重要的是准确性(尽可能减小预测值和实际值的误差)。哪怕牺牲可解释性,也要尽可能提高准确性。

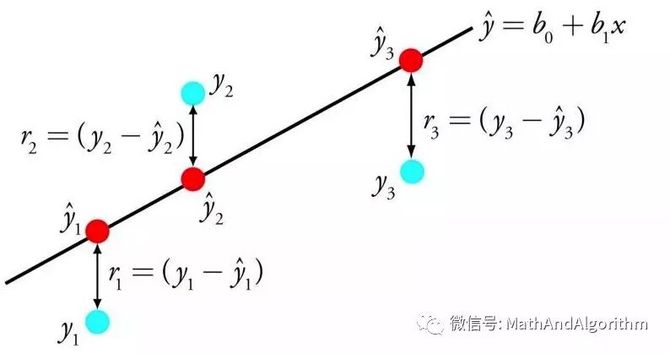

线性回归可用一条线表示输入值X和输出值Y之间的关系,这条线的斜率的值,也叫系数。

从数据中建立线性回归的模型有不同的方法,比方说线性代数的最小二乘法、梯度下降优化。

线多年,相关研究已经很多了。用这个算法关键在于要尽可能地移除相似的变量以及清洗数据。

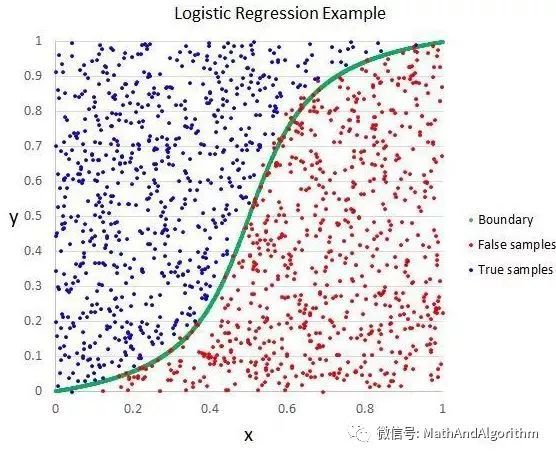

逻辑回归,和线性回归相似,都是要找出输入值的系数权重。不同的地方在于,对输出值的预测改成了逻辑函数。

这个算法还可以用来预测数据分布的概率,适用于需要更多数据论证支撑的预测。

和线性回归相似,如果把和输出不相干的因子或者相近的因子剔除掉的话,逻辑回归算法的表现会更好。

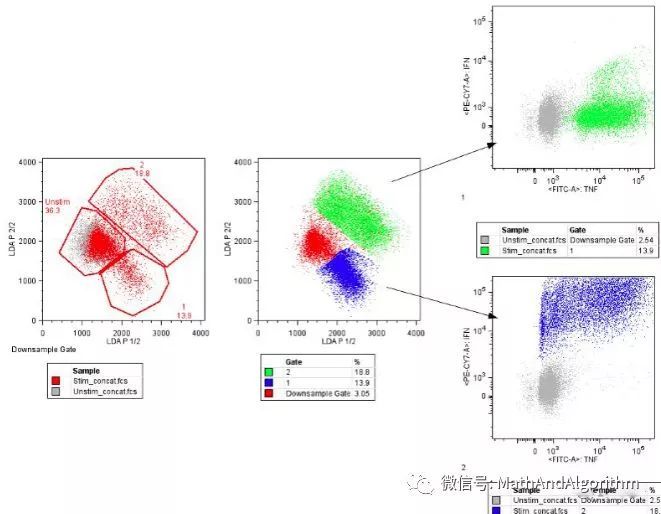

这种算法的可视化结果还比较一目了然,能看出数据在统计学上的特征。这上面的结果都是分别计算得到的,单一的输入值可以是每一类的中位数,也可以是每一类值的跨度。

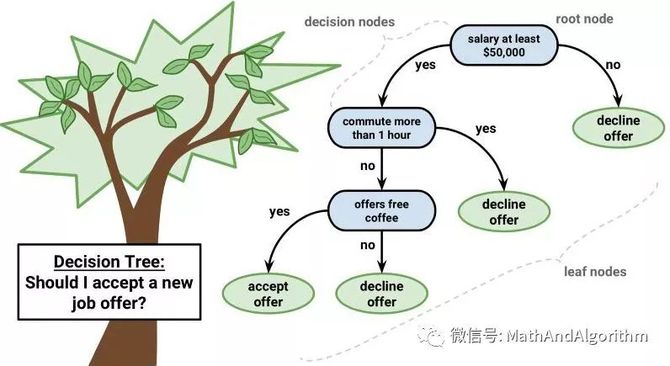

可以用分两叉的树来表示决策树的模型。每一个节点代表一个输入,每个分支代表一个变量(默认变量是数字类型)

决策树的叶节点指的是输出变量。预测的过程会经过决策树的分岔口,直到最后停在了一个叶节点上,对应的就是输出值的分类结果。

决策树很好学,也能很快地得到预测结果。对于大部分问题来说,得到的结果还挺准确,也不要求对数据进行预处理。

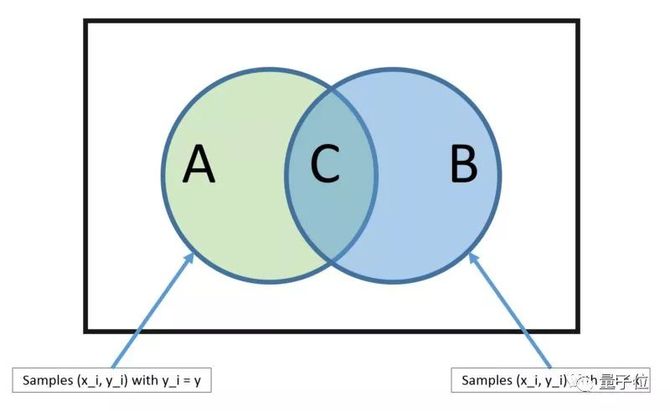

一个是每种输出种类的概率;另外一个,是根据给定的x值,得到的是有条件的种类概率。

当你的数据是实数值,那么按理说应该是符合高斯分布的,也就很容易估算出这个概率。

朴素贝叶斯定理之所以名字里有个“朴素”,是因为这种算法假定每个输入的变量都是独立的。

不过,真实的数据不可能满足这个隐藏前提。尽管如此,这个方法对很多复杂的问题还是很管用的。

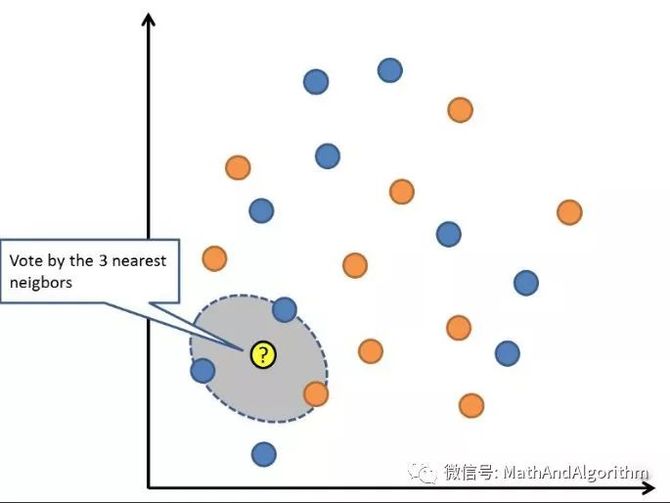

对新数据的预测,是搜索整个训练集的值,找到K个最近的例子(literally的邻居)。然后总结K个输出的变量。

如果你的特征(attributes)属于同一个尺度的话,那最简单的方法是用欧几里得距离。这个数值,你可以基于每个输入变量之间的距离来计算得出。

最近邻法,需要占用大量的内存空间来放数据,这样在需要预测的时候就可以进行即时运算(或学习)。也可以不断更新训练集,使得预测更加准确。

距离或亲密度这个思路遇到更高维度(大量的输入变量)就行不通了,会影响算法的表现。

当(数学)空间维度增加时,分析和组织高维空间(通常有成百上千维),因体积指数增加而遇到各种问题场景。

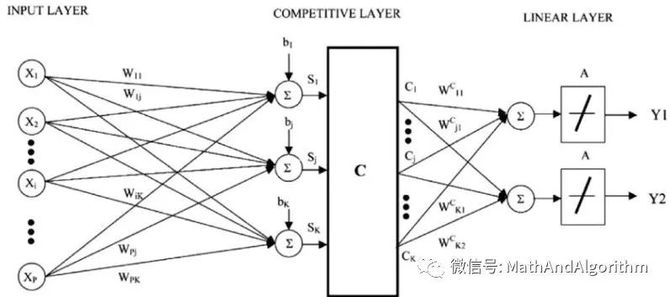

LVQ,是一组矢量,也叫码本。一开始,矢量是随机选的,经过几次学习算法迭代之后,慢慢选出最能代表训练集的矢量。

学习完成后,码本就可以用来预测了,就像最近邻法那样。计算新输入样例和码本的距离,可以找出最相近的邻居,也就是最匹配的码本。

如果你重新调整数据尺度,把数据归到同一个范围里,比如说0到1之间,那就可以获得最好的结果。

如果用最近邻法就获得了不错的结果,那么可以再用LVQ优化一下,减轻训练集储存压力。

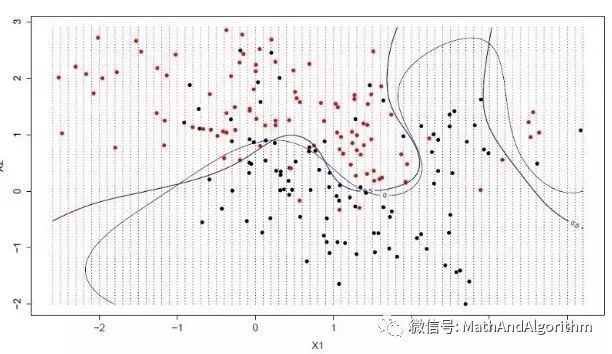

支持向量机的超平面,是能把输入变量空间尽可能理想地按种类切割,要么是0,要么是1。

在二维空间里,你可以把超平面可以分割变量空间的那条“线”。这条线能把所有的输入值完美一分为二。

最理想的超平面,是可以无误差地划分训练数据。也就是说,每一类数据里距离超平面最近的向量与超平面之间的距离达到最大值。

从实际操作上,最理想的算法是能找到这些把最近矢量与超平面值距离最大化的点。

在统计学里,bootstrap是个估算值大小很有效的方法。比方说估算平均值。

从数据库中取一些样本,计算平均值,重复几次这样的操作,获得多个平均值。然后平均这几个平均值,希望能得到最接近真实的平均值。

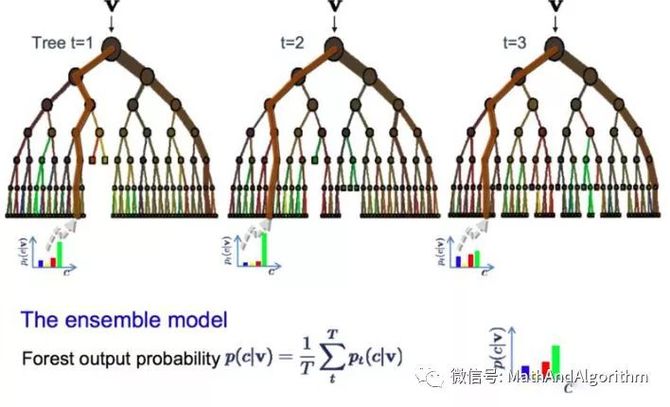

而bagging算法,是每次取多个样本,然后基于这些样本建模。当要预测新数据的时候,之前建的这些模型都做次预测,最后取这些预测值的平均数,尽力接近真实的输出值。

它包含多个决策树的分类器, 并且其输出的类别是由个别树输出的类别的众数而定。

如果你的高方差算法取得了不错的结果(比方说决策树),那么用随机森林的话会进一步拿到更好的结果。

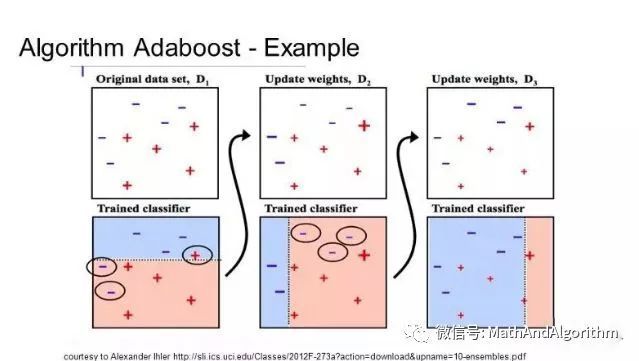

Boosting的核心是,对同一个训练集训练不同的分类器(弱分类器),然后把这些弱分类器集合起来,构成一个九游体育科技更强的最终分类器(强分类器)。

所得到的第二个弱分类器会纠正第一个弱分类器的误差。弱分类器的不断叠加,直到预测结果完美为止。

在第一个树建立出来之后,不同的样本训练之后的表现可以作参考,用不同的样本训练弱分类器,然后根据错误率给样本一个权重。

模型按顺序一个一个建,每个训练数据的权重都会受到上一个决策树表现的影响。

因为训练数据对于矫正算法非常重要,所以要确保数据清洗干净了,不要有奇奇怪怪的偏离值。

其实机器学习的算法很多的,以上只是介绍用得比较多的类型,比较适合萌新试试手找找感觉。